Un article du 31 mai 2017 repris du blog de Nicolas Glady et republié avce l’autorisation de l’auteur

Le contexte de cette expérimentation

Cette expérimentation a eu lieu dans un cours de Marketing où les étudiants apprennent à utiliser des outils quantitatifs d’analyse du comportement des consommateurs, du positionnement d’une entreprise, ou de la stratégie marketing par exemple. L’acquisition des connaissances et des compétences développées en cours par les étudiants est évaluée sur base d’études de cas, aussi proches du réel que possible. La situation d’une entreprise est présentée, et de nombreuses informations sont données (résultats d’un sondage, chiffres de vente, etc.) Les étudiants doivent alors utiliser les méthodologies vues en cours pour analyser la situation et faire des recommandations au management de l’entreprise, comme s’ils étaient des consultants.

Le dispositif se rapproche autant que possible d’un apprentissage par le projet. Il est important de noter que l’objectif n’est pas de répondre à des questions fermées. La situation est au contraire réaliste et la première étape consiste à comprendre la situation et qualifier l’objectif de l’analyse à effectuer. Les travaux sont faits en groupe de quatre étudiants et il est demandé de remettre un travail professionnel, similaire à ce qu’une société de conseil en management pourrait livrer par exemple. Ce qui rend très difficile un processus « numérisé » d’évaluation (comme ce serait le cas pour un QCM.)

L’expérimentation d’évaluation par les pairs a eu lieu lors de la cinquième séance du cours. Les étudiants avaient déjà pu me rendre un premier travail que j’avais donc pu évaluer. Ce qui leur a donné une idée précise de ce qui était attendu et de la manière dont les rendus doivent être évalués. Pour chaque groupe, une analyse détaillée des « forces » (ce qui est bien fait et important) et des « points d’attention » (ce qui devrait être amélioré) est donnée. Des exemples précis de ce qui est à faire ou pas sont repris directement sur les slides des étudiants. Un document de synthèse (aussi présenté en cours) est donné quelques jours après la remise aux étudiants. Ils peuvent y trouver un feedback général, leurs notes, et pour chaque groupe, comme décrit précédemment ses forces et ses points d’attention, ainsi que les exemples précis repris depuis les slides. La note est elle aussi décomposée en plusieurs parties : méthodologie, conclusion, clarté de la narration, descriptions des données, etc.

J’insiste beaucoup sur le fait que je les encourage à voir ce que les autres ont fait de bien. Non seulement pour pouvoir comprendre ce qu’ils auraient pu faire de mieux, mais aussi pour qu’ils comprennent que comme il s’agit d’un cas réel, il n’y a pas vraiment de réponse parfaite. Je demande aussi à un groupe – souvent au meilleur, ou en tous cas celui dont l’analyse est la plus « pro » – de présenter en classe et nous discutons en détail de ce qui est bien et de ce qui aurait pu être amélioré pour ce cas précis.

Le fait d’avoir tenu une première évaluation « descendante » (de la part du professeur) mais en séance, visait un objectif multiple. Tout d’abord, il convient de donner aux étudiants un « point de référence » par rapport aux attentes. En donnant une première série de notes, la « barre est placée » pour la suite, et ce qui correspond à un 10 ou un 15 est établi. Ensuite, cela permet d’insister sur le principe que, plus que la note, c’est la motivation de celle-ci (forces et points d’attention) qui est cruciale. Non seulement un jugement n’est juste que s’il est motivé, mais en plus, l’objectif est bien d’aider les étudiants à s’améliorer, pas uniquement de les sanctionner. Enfin, en ayant la discussion en classe sur les forces et les points d’attention, la dynamique d’évaluation collective était amorcée.

Pourquoi une évaluation par les pairs ?

Pour les étudiants, l’avantage d’une évaluation par les pairs est multiple. Tout d’abord, on apprend en général énormément en portant une critique sur le travail d’autrui. « La meilleure façon d’apprendre quelque chose, c’est de chercher à l’expliquer à quelqu’un. » Et comme je l’expliquerai plus loin, l’évaluation devra être motivée et donc les étudiants devront porter un esprit critique sur leur propre évaluation. Ensuite, comme il n’existe pas en matière de stratégie marketing une solution unique, cela leur permet de comparer les différentes manières d’approcher ou même de qualifier une même problématique. Enfin, en tant que futur manager, ils seront tôt ou tard en situation d’évaluer autrui, et leur permettre de se former à développer une évaluation constructive me semble être dans la mission d’une école de commerce.

Pour le professeur, outre l’objectif pédagogique décrit précédemment, il y a un enjeu de mise à l’échelle. La méthode de cas est souvent vue comme beaucoup plus pertinente qu’une méthode basée sur des choix multiples ou des questions fermées. Mais elle est cependant beaucoup plus chronophage pour la personne chargée d’évaluer les travaux. Evaluer 600 copies avec des choix multiples peut être facilement automatisé. C’est beaucoup plus difficile pour des questions ouvertes comme des rédactions ou des analyses de cas. L’évaluation par les pairs offre alors un dispositif qui semble pouvoir permettre l’évaluation d’un très grand nombre de travaux.

Lorsque j’ai présenté l’idée aux étudiants, à nos ingénieurs pédagogiques, ou à la direction des programmes, pour les raisons décrites ci-dessus, je n’ai eu que des retours positifs et des encouragements. A la condition bien sûr que la note resterait au final de la responsabilité du professeur. J’ai donc pris l’engagement que si l’analyse détaillée, la décomposition de la note et la motivation de celle-ci seraient faites par « des pairs », leur évaluation serait validée par le professeur. Je me suis donc bien engagé à ce qu’en fin de compte, toutes les évaluations soient vérifiées, validées, et éventuellement ajustées par moi.

Préparation de la séance d’évaluation par les pairs

Avant la séance, nous avons préparé un déroulé, déterminé les groupes et préparé les différents documents qui seraient nécessaires aux étudiants.

La séance se tiendrait dans une grande salle plate, pour que les personnes qui encadrent (le professeur et éventuellement des moniteurs/assistants) puissent circuler entre les tables. A l’entrée de la salle, les étudiants pourront trouver la table à laquelle ils ont été assignés. Chaque table est constituée de 4 étudiants, provenant de groupes différents, et qui n’auront pas à évaluer leurs propres travaux. Par exemple, les étudiants de la table A proviennent des groupes 2, 3, 4 et 5 et évalueront les travaux du groupe 1 et 20.

Les étudiants sont au nombre de 80 pour ce cours. Il y a donc au total 20 tables. Sur chaque table, se trouvent des copies des deux cas qu’il faudra évaluer, une description du déroulé, une grille d’évaluation et un document décrivant précisément ses critères (un exemple peut être trouvé ici.) Le déroulé exact est décrit à la section suivante.

Les étudiants doivent lire les deux rendus, préparer une évaluation individuelle, en discuter en groupe, et produire enfin une synthèse. C’est au « chef de table » (nommé en début de séance) à arriver à produire un consensus. L’idée de faire travailler chaque table sur deux rendus vise deux objectifs : d’une part permettre aux étudiants de comparer les deux travaux (et donc d’avoir une certaine base de comparaison aussi par rapport à leurs propres travaux) et d’avoir deux consensus différents puisque chaque rendu sera évalué par deux tables différentes. La discussion qui suit l’évaluation individuelle a aussi pour objectif de faire prendre conscience aux étudiants du caractère ambigu de la situation décrite dans le cas et du fait « qu’aucune solution n’est parfaite ». Cette approche critique et dialectique enfin permet aux étudiants d’atteindre les objectifs pédagogiques de réflexion sur leur propre compréhension décrits plus haut.

Le jour J

La séance était prévue sur 3 heures de 16h30 à 19h30. Le tableau indiquant les tables et les groupes avait été préparé à l’avance, les tables avaient été disposées comme prévu et les rendus, les documents décrivant les critères d’évaluation, et des feuilles blanches pour qu’ils puissent écrire les « forces et points d’attention » attendaient les étudiants sur les tables. Nous nous étions assurés qu’aucun groupe ne serait de moins de 3 personnes en cas d’absence des étudiants.

J’ai envoyé sur un répertoire en ligne partagé tous les rendus à tous les étudiants. J’ai aussi joint un document qui donnait un débrief général sur le cas en question.

Le déroulé était le suivant :

- De 16h30 à 16h35 : installation des étudiants et désignation du chef de table.

- De 16h35 à 16h45 : prise de connaissance des instructions et ré-explications des différents éléments de la note.

- De 16h45 à 17h15 : les étudiants ont lu individuellement les deux rendus qu’ils avaient à évaluer.

- A 17h15 à 17h15 : avant qu’ils évaluent les travaux, je leur ai rappelé l’importance de bien motiver la note. Le principe était que pour tout élément de la grille d’évaluation, il fallait donner une explication qui justifie la note donnée.

- De 17h15 à 17h35 : évaluation individuelle du premier cas

- De 17h35 à 17h55 : évaluation individuelle du deuxième cas

- A 17h55 : rappel de la méthode de synthèse. Afin d’être efficaces, les tables devaient d’abord simplement faire une moyenne de toutes les notes individuelles. Ensuite, et seulement en cas de divergence, les éléments de la note où il n’y avait pas de consensus devaient être discutés.

- De 17h55 à 18h35 : synthèse du premier cas.

- De 18h35 à 19h05 : synthèse du deuxième cas.

Je pensais que ce dispositif ne fonctionnerait dans le temps imparti que parce que les étudiants avaient déjà une très bonne connaissance du cas en question. Ayant travaillé sur son analyse depuis deux semaines, les étudiants n’avaient qu’à comparer le travail effectué par les autres groupes avec leurs propres analyses et conclusions. En pratique, les étudiants ont en réalité fini les évaluations plus tôt que prévu (voir plus bas.)

Au final, l’évaluation moyenne n’était pas significativement différente de ce que j’avais l’habitude de donner. Et les notes étaient très cohérentes entre les tables qui évaluaient les mêmes groupes. Il n’y a eu que 4 groupes sur les 20 où les notes variaient de plus de 2.5 points entre les tables ; et il n’y avait pas de groupe dont les évaluations différaient de plus de 5. Et les commentaires « quali » étaient eux très cohérents. Mon rôle s’est donc surtout limité à synthétiser les évaluations qualitatives, à en vérifier les incohérences (mais il n’y en avait quasiment aucune : les différentes tables travaillant sur le même cas avaient des avis très similaires), et surtout à m’assurer de la cohérence entre le qualitatif et le quantitatif.

Le retour des étudiants

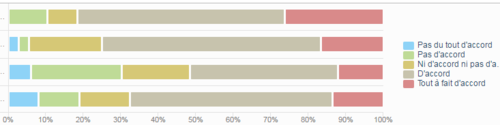

A l’issue de cette séance, j’ai décidé de faire un sondage de la perception que les étudiants en avaient eue. La première série de questions était la suivante :

– 1 Cette séance m’a permis de mieux comprendre comment aborder les cas

– 2 Par rapport à une évaluation classique (ex : notations données dans d’autres cours), ce dispositif m’est plus utile dans mon apprentissage ? (« Ni d’accord ni pas d’accord » = utilité similaire)

– 3 Par rapport à une évaluation classique, ce dispositif produit une évaluation plus pertinente ? (« Ni d’accord ni pas d’accord » = pertinence similaire)

Je recommanderais d’appliquer ce dispositif à d’autres cours.

La figure ci-dessous synthétise les retours des répondants pour ces quatre questions.

Les étudiants sont à 80% d’accord ou tout à fait d’accord que cette séance leur a permis de mieux comprendre comment aborder les cas. 75% trouvent que ce dispositif leur est plus utile qu’une évaluation traditionnelle. Mais la pertinence de l’évaluation n’est pas, elle, vu comme nécessairement meilleure (c’est sur ce point que les résultats sont les plus divisés, en gardant toutefois une majorité « pour » le dispositif.) On voit enfin que les répondants sont dans leur grande majorité positifs à l’égard de ce dispositif dans sa globalité : en effet, 68% d’entre eux le recommandent. (J’avais d’ailleurs indiqué que si je n’avais pas « de majorité forte » à cet égard, je ne ré-itérerais sans doute pas ce dispositif.) Il est cependant remarquable de constater qu’une part non négligable des répondants n’a pas vraiment apprécié l’expérience.

Au global, comme attendu, il apparaît que ce dispositif améliore surtout l’apprentissage et la compréhension pour l’étudiant plus que l’évaluation elle-même. Si l’évaluation est sans doute d’un niveau similaire à celle donnée par un professeur (voir ci-dessus), l’étudiant tire beaucoup plus d’enseignements du dispositif « par les pairs » que quand il se contente d’être « consommateur passif » de l’évaluation…

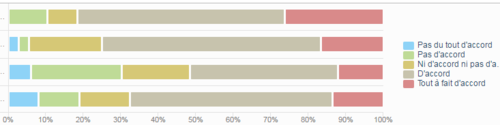

La question suivante était un vote : pensez-vous que ce dispositif « 1) ne devrait plus être utilisé », « 2) pourrait se substituer au dispositif d’évaluation traditionnel », « 3) est complémentaire au dispositif d’évaluation traditionnel ». Comme l’indique la figure ci-dessous, 84% des répondants jugent que ce dispositif est complémentaire. 13% jugent cependant que ce dispositif ne devrait plus être utilisé.

Un dispositif à améliorer en continu

Dans une perspective d’approcher le dispositif lui-même dans une démarche critique et constructive, j’ai aussi demandé aux étudiants d’indiquer ce qu’ils voyaient comme forces de notre expérimentation, et ce qui devrait être amélioré.

Parmi les forces de cette approche, les étudiants ont indiqué : la prise de recul, la meilleure acquisition de la compréhension de la méthode des cas et de la méthode d’évaluation, la dynamique dialectique avec les autres, tout ceci amenant sans doute à une meilleure performance lors des prochains travaux. Dans l’ensemble, les retours à ce niveau étaient très positifs et nombreux mais allaient tous dans le même sens : « c’est très utile pour nous ! »

Nous avons identifié des petits ajustements qui mériteraient d’être faits. Très pratiquement, il faut laisser le temps aux équipes de coordination (coordinatrice du cours, équipes d’impression,…) de réceptionner les documents afin de les préparer pour la séance le jour J si on veut un document d’analyse imprimé par table pour les deux travaux à évaluer par exemple. Certains étudiants auraient aussi aimé avoir les documents un peu à l’avance. Il faudrait aussi plus digitaliser le processus : typiquement les synthèses qualitatives et quantitatives des évaluations pourraient être transmises en format électronique. J’avais malheureusement oublié d’anonymiser les travaux et ceci doit être fait pour des raisons évidentes d’absence de biais. Nous nous sommes aussi rendu compte que deux heures (et non trois) étaient amplement suffisantes. Enfin, et plus généralement, les étudiants ont souligné la difficulté d’évaluer rigoureusement et systématiquement des cas très « soft-skills » et ouverts.

Et vous ? Avez-vous déjà eu l’occasion d’expérimenter des dispositifs similaires ? N’hésitez pas à laisser en commentaires vos retours d’expérience !

Répondre à cet article

Suivre les commentaires : |

|